Construindo Chatbots: Do AIML e PLN até os Modernos LLMs

2025-12-16

Teoria e Prática com Python

| Preparação e revisão | Giseldo Neo e Alana Neo |

| Diagramação | Giseldo Neo |

| versão 0.8 (gerado em 2025-12-16) | |

| E-mail: giseldo@gmail.com | |

| Todos os direitos reservados. | |

| Nenhuma parte desta publicação | |

| poderá ser armazenada ou reproduzida | |

| por qualquer meio sem a autorização | |

| por escrito dos autores. | |

Agradecimentos

Expresso minha gratidão ao Professor Dr. Olival de Gusmão Freitas Júnior (UFAL) pela cuidadosa revisão deste livro, cujo olhar crítico contribuiu para elevar a qualidade do trabalho. Agradeço especialmente ao Pesquisador Dr. Joaquim José Cintra Maia Honório pelo auxílio no capítulo dos LLMs e Fine-Tuning; essas contribuições foram importantes e melhoraram muito o texto a partir do rascunho original. Agradeço ao Professor Dr. Evandro de Barros Costa (UFAL) pela apresentação do ELIZA; ao Professor Dr. José Antão Beltrão Moura (UFCG) pela inspiração e dedicação ao ensino; e agradeço ao Professor Msc. Otávio Monteiro Pereira (IFAL) pelo apoio relacionado à ética dos chatbots. Agradeço também ao Instituto Federal de Alagoas e a seus servidores. Estendo meus agradecimentos a todos que, de forma direta ou indireta, colaboraram com ideias, discussões e sugestões que enriqueceram o conteúdo apresentado.

Giseldo Neo

Agradeço à minha família, que sempre esteve ao meu lado em cada etapa desta jornada. Aos meus pais, pelo amor, paciência e incentivo incondicional. Aos parentes, pelo apoio e pela compreensão das ausências nos momentos de dedicação intensa. Agradeço também aos amigos e colegas que contribuíram com ideias, sugestões e palavras de motivação nos dias desafiadores. Este livro é fruto não apenas do meu esforço, mas também da força coletiva daqueles que acreditaram e apoiaram para que esta obra se tornasse realidade.

Alana Neo

Prefácio

Vivemos um momento histórico em que a inteligência artificial (IA) deixou de ser apenas tema de ficção científica para se tornar parte do nosso cotidiano. Os chatbots, os avanços em Processamento de Linguagem Natural (PLN) e os Modelos de Linguagem Grande (LLMs) são hoje protagonistas dessa transformação, moldando a forma como nos comunicamos, aprendemos, trabalhamos e interagimos com a tecnologia.

O que antes era limitado a sistemas rígidos, que apenas repetiam respostas pré-programadas, evoluiu para assistentes virtuais capazes de compreender contexto, interpretar nuances da linguagem e até gerar conteúdo inédito. Essa trajetória revela não apenas conquistas tecnológicas, porém também desafios éticos, sociais e econômicos.

Este livro é um convite acessível e profundo para quem deseja compreender como nascem, evoluem e funcionam os chatbots — desde os primórdios com ELIZA até os modernos modelos de linguagem como o ChatGPT. Ele nasce com o propósito de explicar, refletir e inspirar. Explicar como o PLN e os LLMs funcionam e por que se tornaram tão relevantes. Refletir sobre os impactos dessa revolução: o futuro do trabalho, a responsabilidade no uso da IA, a relação entre humano e máquina. Inspirar pesquisadores, profissionais, estudantes e curiosos a explorar esse campo em rápida expansão, contribuindo para um uso responsável e criativo dessas ferramentas tecnológicas. Ele também é um convite para explorar esse universo fascinante. Você encontrará explicações sobre como essas tecnologias funcionam, exemplos e reflexões sobre seus impactos na sociedade. Mais do que compreender as máquinas que conversam, trata-se de entender o futuro da linguagem e da interação entre humanos e sistemas inteligentes.

Seja você estudante, pesquisador ou profissional do mercado, este livro pode inspirar novas ideias e mostrar como a inteligência artificial conversacional já está transformando o presente — e continuará a transformar o futuro.

Boa leitura!

Informações

O código-fonte - com os mesmos códigos em python utilizados neste livro - está disponível no endereço:

Uma versão atualizada do livro pode ser encontrada no site

Citação Formato ABNT:

Neo, Giseldo da Silva & Neo Alana Viana Borges da Silva. Construindo Chatbots: Do AIML e PLN até os Modernos LLMs. 2025. Edição do autor.

Citação Bibtex:

@book{neoneo2025,

author = {Giseldo da Silva Neo & Alana da Silva Neo},

title = {Construindo Chatbots: Do AIML e PLN até

os Modernos LLMs},

year = 2025,

publisher = {Edição do autor}

}Resumo

Se você já se perguntou como funcionam os chatbots que conversam como humanos, este livro é a sua porta de entrada para um dos campos mais fascinantes da inteligência artificial. Ele é mais do que um guia técnico — é uma jornada envolvente pela evolução, construção e futuro dos agentes conversacionais, unindo clareza didática com profundidade técnica. A obra começa explorando o conceito de chatbot, diferenciando suas principais categorias — conversacionais e orientados a tarefas — e contextualizando o leitor com um panorama histórico que vai do lendário ELIZA, criado nos anos 1960, até os impressionantes modelos atuais como ChatGPT. Essa viagem no tempo é pontuada por explicações acessíveis e exemplos práticos em Python que mostram, passo a passo, como esses sistemas funcionam por trás das cortinas. O livro se destaca por traduzir conceitos complexos em linguagem clara. Você vai entender o que é o pattern matching usado por chatbots clássicos, como funciona o AIML, e por que expressões regulares ainda são ferramentas utilizadas no desenvolvimento de bots. Em capítulos dedicados ao Processamento de Linguagem Natural (PLN), técnicas como tokenização, lematização e análise sintática ganham vida por meio de exemplos aplicáveis, preparando o leitor para dar seus próprios passos no mundo da IA conversacional. Mas ele não se limita ao passado. Ele mergulha fundo nas tecnologias que revolucionaram o campo, como Transformers, Word2Vec e os Modelos de Linguagem Grande (LLMs), incluindo BERT, GPT e LLaMA. O leitor descobre como essas arquiteturas funcionam, como treiná-las e como aplicá-las usando frameworks modernos como Hugging Face e LangChain. Além de guiar a construção técnica de um chatbot — do código ao deploy — o livro também traz reflexões sobre ética, privacidade e o impacto social desses agentes. Tópicos como personalização, explicabilidade e segurança ampliam o olhar do leitor para além da implementação. Combinando teoria, prática e visão de futuro, ele é um convite para programadores, educadores, empreendedores e curiosos que desejam dominar a arte de construir diálogos entre humanos e máquinas. É uma obra que ensina, inspira e instiga. Se você quer entender como os chatbots realmente pensam — ou pelo menos como fingem tão bem — este livro é para você.

Introdução

“Podemos ver apenas uma curta distância à frente, mas pode-se ver muito que precisa ser feito.”

Alan Turing

Objetivo Apresentar os conceitos fundamentais de chatbots, sua classificação, histórico e principais abordagens, preparando o leitor para compreender a evolução dessas tecnologias.

Contexto

Para uma parcela da população com maior afinidade com a inteligência artificial, o chatbot tornou-se uma ferramenta essencial para executar tarefas, redigir e-mails e traduzir textos. O que um dia causou espanto e admiração — como ocorreu com a descoberta do fogo, o computador pessoal, a Internet, as ferramentas de busca e as redes sociais — hoje se converteu em dependência.

Neste contexto, um chatbot é um programa de computador que simula uma conversa humana, via texto ou áudio, oferecendo respostas diretas a perguntas e apoiando diversas atividades, desde conversas gerais até ações específicas, como abrir uma conta bancária ou agendar um voo para o show do seu cantor preferido.

Para entender como chegamos a esse ponto, vale recordar a trajetória do próprio conceito. Embora o programa ELIZA, criado por Weizenbaum (1966), seja frequentemente citado como um dos primeiros exemplos de software conversacional, o termo “chatbot” ainda não era empregado à época. Sua origem remete a “chatterbot” — sinônimo de “chatbot” —, popularizado por Michael Mauldin em 1994 ao descrever seu programa JULIA (Mauldin 1994). Anos depois, outras publicações acadêmicas, como os anais da Virtual Worlds and Simulation Conference de 1998 (Jacobstein et al. 1998), contribuíram para consolidar os termos entre os pesquisadores.

O chatbot ELIZA representou um experimento marcante na interação entre humano e computador (Weizenbaum 1966). Seu roteiro (ou script) mais famoso, o DOCTOR, imitava rudimentarmente um psicoterapeuta, utilizando correspondência de padrões simples. Por exemplo, quando um usuário inseria a frase “Estou triste” no ELIZA, o programa respondia “Por que você está triste hoje?”, reformulando a entrada do usuário como uma pergunta. O funcionamento básico do sistema baseava-se em um conjunto restrito de regras e substituições, o que lhe permitia apenas uma compreensão superficial e limitada da linguagem humana.

O roteiro DOCTOR do ELIZA adequou-se bem a um tipo de diálogo mais simples, pois suas respostas dependiam de pouco conhecimento sobre o ambiente externo. As regras no roteiro permitiam que o programa respondesse ao usuário com outras perguntas ou simplesmente refletisse a afirmação original.

NOTA

Uma descrição detalhada do funcionamento do ELIZA e o roteiro DOCTOR, com exemplos em Python, será apresentada no Capítulo 3.

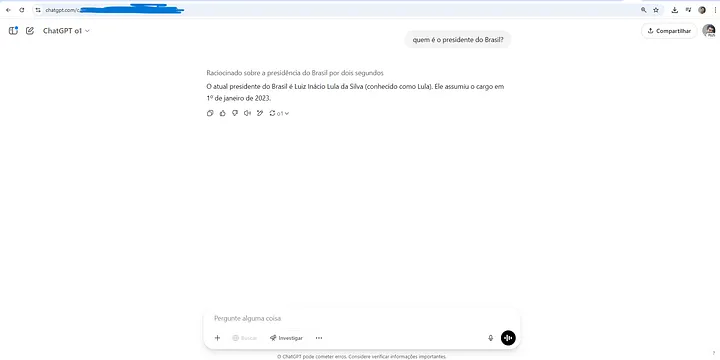

Outro chatbot famoso é o ChatGPT da OpenAI. Ele é um programa capaz de gerar texto muito semelhante ao criado por humanos. Ele utiliza redes neurais, com aprendizagem profunda, para gerar sentenças e parágrafos com base nas entradas e informações fornecidas. Entre suas capacidades, ele pode traduzir e resumir textos, responder a perguntas e explicar conceitos. Contudo, o ChatGPT não possui consciência nem a capacidade de compreender contexto ou emoções.

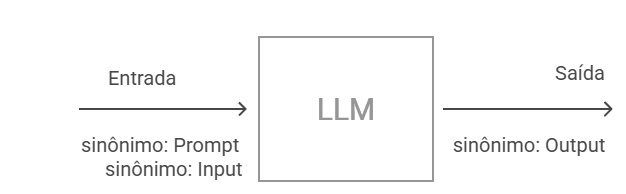

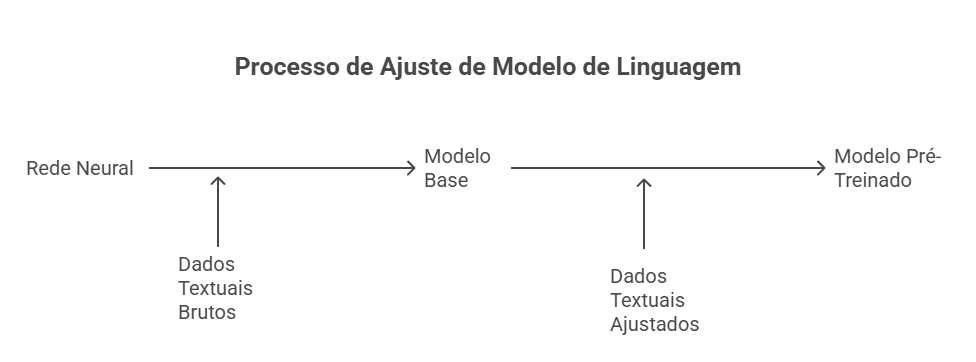

O chatGPT é um exemplo de Modelo de Linguagem Grande (em inglês Large Language Model - LLM), baseado na arquitetura Transformers, introduzida em 2017 (Vaswani et al. 2017). Modelos deste tipo são treinados com terabytes de texto, utilizando mecanismos de autoatenção que avaliam a relevância de cada palavra em uma frase. Ao contrário das regras manuais do ELIZA, os LLMs extraem padrões linguísticos a partir da vasta quantidade de dados com que a rede neural foi treinada.

Esses dois chatbots, ELIZA e ChatGPT, são bons representantes do tipo de chatbot conversacional. Apesar de terem surgido com décadas de diferença — ELIZA em 1966 e ChatGPT em 2022 — e de diferirem bastante na forma como geram suas respostas, ambos compartilham semelhanças em seu objetivo: conversar sobre determinado assunto ou responder perguntas, mantendo o usuário em um diálogo fluido quando necessário. Chatbots com essas características podem ser agrupados, de acordo com o objetivo, como chatbots conversacionais e são utilizados para interagir sobre assuntos gerais.

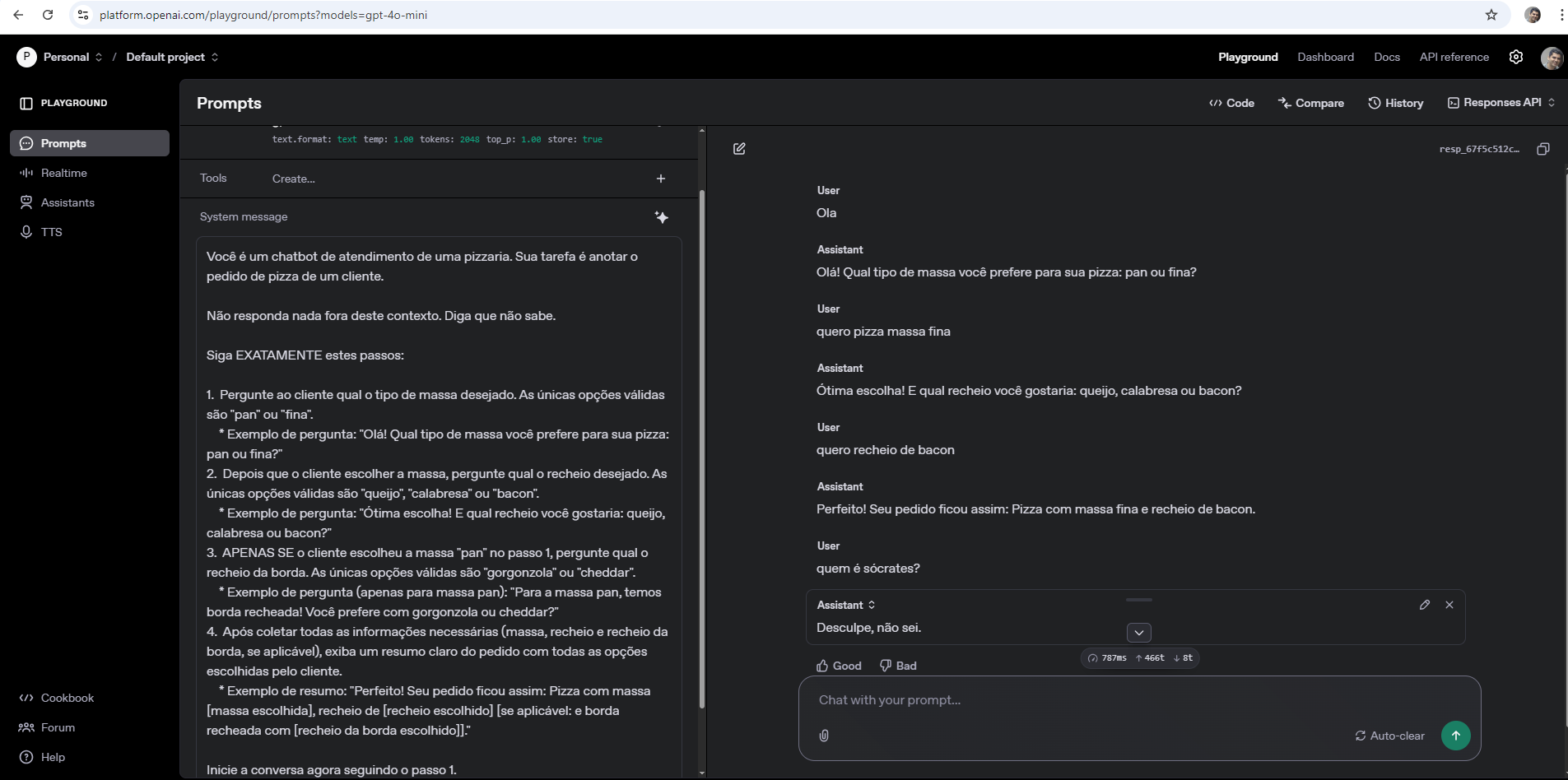

Outro tipo de chatbot classificado em relação ao objetivo é o chatbot orientado a tarefas. Os chatbots orientados a tarefas executam ações específicas, como abrir uma conta bancária ou pedir uma pizza. Geralmente, as empresas disponibilizam chatbots orientados a tarefas para seus usuários, com regras de negócio embutidas na conversação e com fluxos bem definidos. Normalmente, não se espera pedir uma pizza e, no mesmo chatbot, discutir os estudos sobre Ética do filósofo Immanuel Kant (embora talvez haja quem queira).

Essas duas classificações, “conversacional” e “orientado a tarefas”, ainda não são suficientes para uma completa classificação. Existem outras classificações que serão discutidas em seções posteriores. Além disso, uma abordagem híbrida, unindo funções de chatbots do tipo “conversacional” e “orientado a tarefas” vem sendo utilizada para atender às necessidades dos usuários.

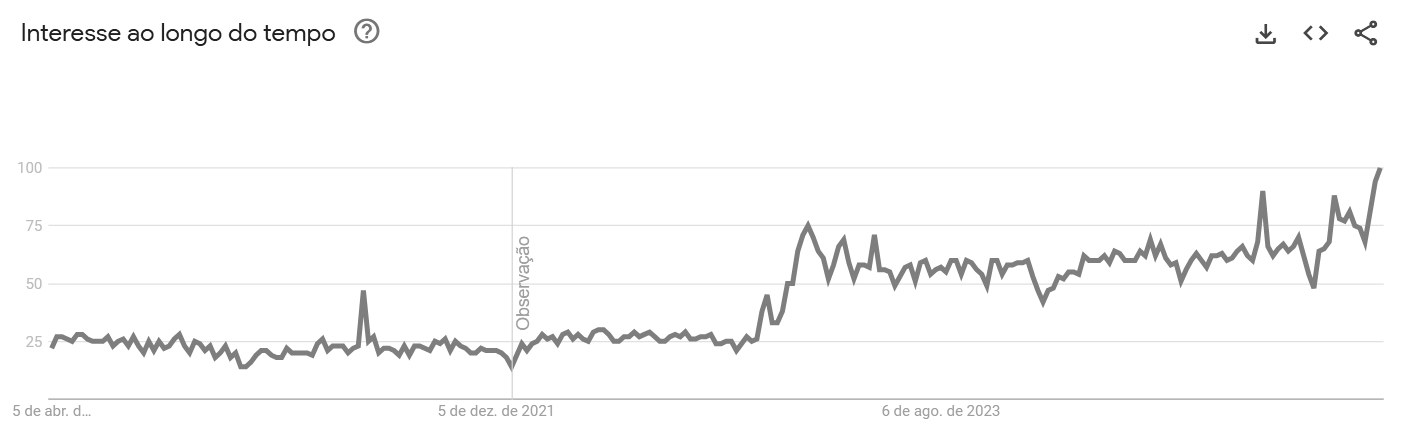

A popularidade dos chatbots tem crescido significativamente em diversos domínios de aplicação (Marcondes, Almeida, and Novais 2020; Klopfenstein et al. 2017; Sharma, Verma, and Sahni 2020). Essa tendência é corroborada pelo aumento do interesse de busca pelo termo “chatbots”, conforme análise de dados do Google Trends no período entre 2020 e 2025 (Figura 2.1). Nesta figura, os valores representam o interesse relativo de busca ao longo do tempo, onde 100 indica o pico de popularidade no período analisado e 0 (ou a ausência de dados) indica interesse mínimo ou dados insuficientes.

Fonte: Google Trends acesso em 05/04/2025

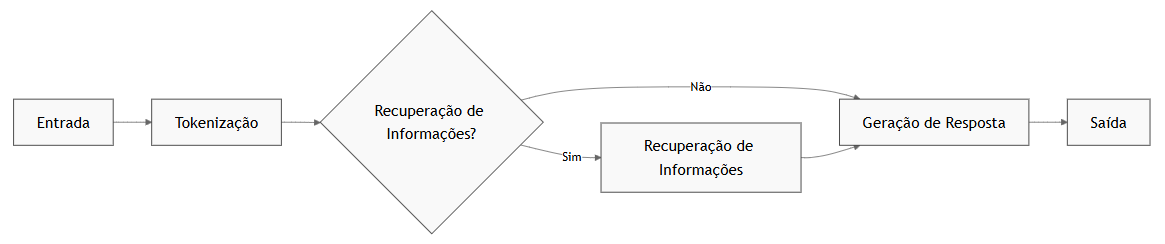

Agentes

Os termos “chatbots” e “agentes” são usadas indiscriminadamente, o que pode causar confusão. Vamos a uma definição mais precisa. Um chatbot é um programa computacional projetado para interagir com usuários por meio de linguagem natural. Por outro lado, o conceito de agente possui uma definição mais ampla. Um agente trata-se de uma entidade computacional que percebe seu ambiente por meio de sensores e atua sobre esse ambiente por meio de atuadores.

Nesse contexto, um chatbot (Figura 2.3) pode ser considerado uma instanciação específica de um agente - veja na Figura 2.2 a arquitetura conceitual de alto nível para um agente - cujo propósito primário é a interação conversacional em linguagem natural.

Fonte: Adaptado de (Russel and Norving 2013)

Com o advento de modelos de linguagem, como os baseados na arquitetura Generative Pretrained Transformer (GPT), a exemplo do ChatGPT, observou-se uma recontextualização do termo “agente” no domínio dos sistemas conversacionais. Nessa abordagem mais recente, um sistema focado predominantemente na geração de texto conversacional tende a ser denominado “chatbot”. Em contraste, o termo “agente” é frequentemente reservado para sistemas que, além da capacidade conversacional, integram e utilizam ferramentas externas (por exemplo, acesso à Internet, execução de código e interação com APIs) para realizar tarefas complexas e interagir proativamente com o ambiente digital. Um sistema capaz de realizar uma compra online, processar um pagamento e confirmar um endereço de entrega por meio do navegador do usuário seria, portanto, classificado como um agente, diferentemente de chatbots mais simples como ELIZA, ou mesmo versões mais simples do chatGPT (GPT-2), cujo foco era estritamente o diálogo.

Fluxo Conversacional

Um chatbot responde a uma entrada do usuário. Porém, essa interação textual mediada por chatbots não se constitui em uma mera justaposição aleatória de turnos de conversação ou pares isolados de estímulo-resposta. Pelo contrário, espera-se que a conversação exiba coerência e mantenha relações lógicas e semânticas entre os turnos consecutivos. O estudo da estrutura e organização da conversa humana é abordado por disciplinas como a Análise da Conversação.

No contexto da análise da conversação em língua portuguesa, os trabalhos de Marcuschi (Marcuschi 1986) são relevantes ao investigar a organização dessa conversação. Marcuschi analisou a estrutura conversacional em termos de unidades coesas, como o “tópico conversacional”, que agrupa turnos relacionados a um mesmo assunto ou propósito interacional.

Conceitos oriundos da Análise da Conversação, como a gestão de tópicos, têm sido aplicados no desenvolvimento de chatbots para aprimorar sua capacidade de manter diálogos coerentes e contextualmente relevantes com usuários humanos (Neves and Barros 2005).

Na prática de desenvolvimento de sistemas conversacionais, a estrutura lógica e sequencial da interação é frequentemente modelada e referida como “fluxo de conversação” ou “fluxo de diálogo”. Contudo, é importante ressaltar que a implementação explícita de modelos sofisticados de gerenciamento de diálogo, inspirados na Análise da Conversação, não é uma característica universal de todos os chatbots, variando conforme a complexidade e o propósito do sistema.

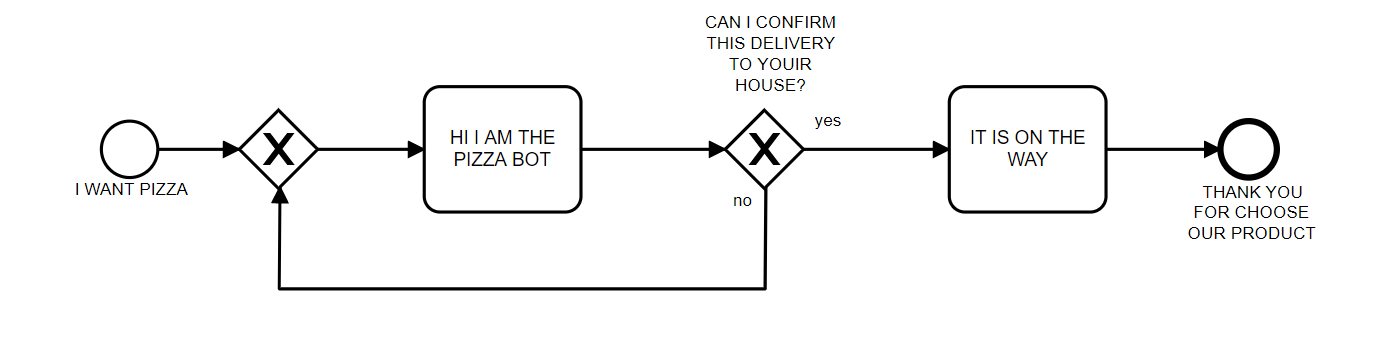

Um exemplo esquemático de um fluxo conversacional é apresentado na Figura 2.4. Nesta figura, o fluxo de conversação inicia quando o usuário entra com o texto: I WANT PIZZA, o chatbot responde com uma pergunta: HI I AM THE PIZZA BOT. CAN I CONFIRM THIS DELIVERY TO YOUR HOUSE? O usuário então pode responder: YES, e o chatbot finaliza a conversa com: IT’S ON THE WAY. THANK YOU FOR CHOOSE OUR PRODUCT. Caso o usuário responda: NO, o chatbot responde com a pergunta original: HI I AM THE PIZZA BOT. CAN I CONFIRM THIS DELIVERY TO YOUR HOUSE? O fluxo de conversação continua até que o usuário responda com um “YES” para a pergunta inicial. Essa estrutura de perguntas e respostas é comum em chatbots orientados a tarefas, onde o objetivo é guiar o usuário por um processo específico, tal como fazer um pedido de pizza.

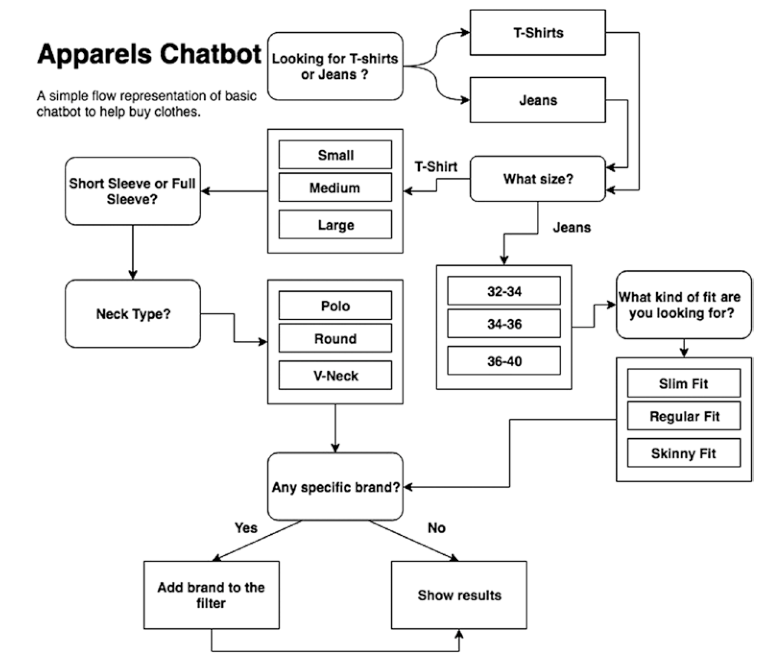

Um outro tipo de fluxo para um chatbot que vende roupas online está representado na Figura 2.5.

Retirado de (Raj 2019).

Histórico

Um marco significativo na evolução dos chatbots depois do ELIZA foi o ALICE, que introduziu a Artificial Intelligence Markup Language (AIML), uma linguagem de marcação baseada em XML (Richard S. Wallace 2000). A AIML estabeleceu um paradigma para a construção de agentes conversacionais ao empregar algoritmos de correspondência de padrões. Essa abordagem utiliza modelos pré-definidos para mapear as entradas do usuário a respostas correspondentes, permitindo a definição modular de blocos de conhecimento (Richard S. Wallace 2000).

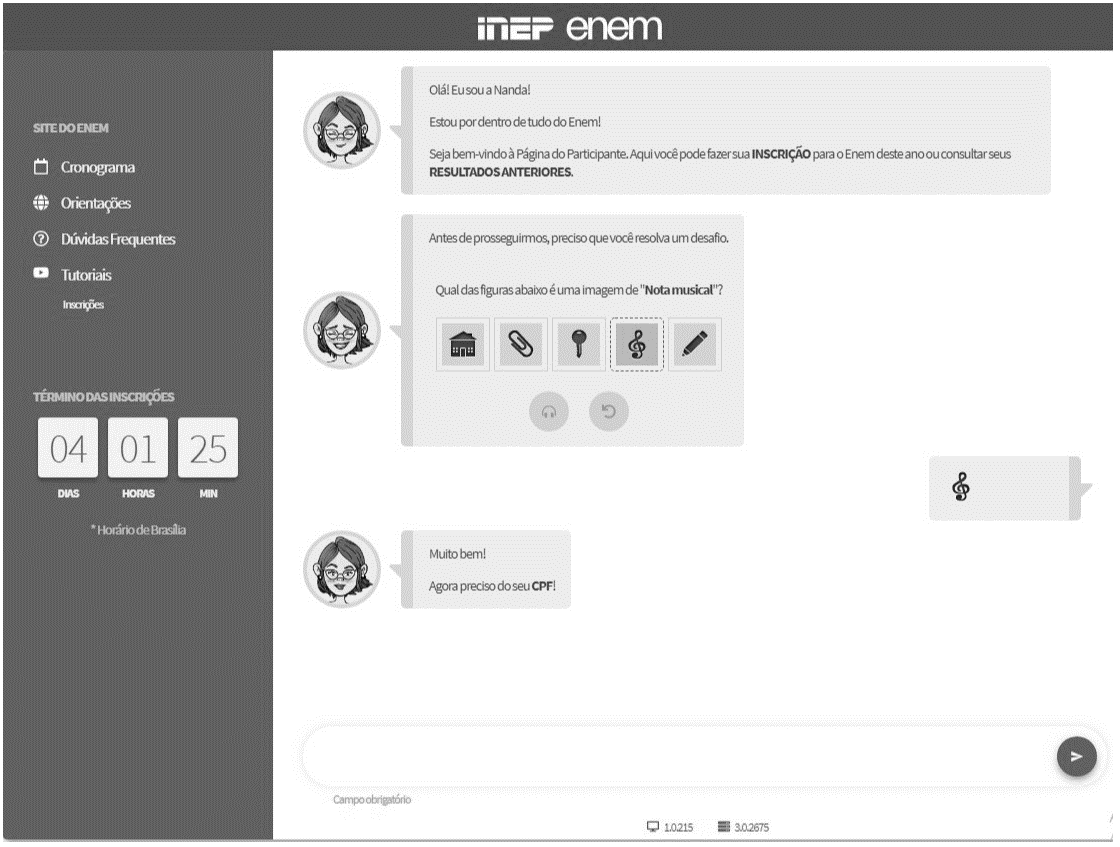

No contexto brasileiro, um dos primeiros chatbots documentados capaz de interagir em português, inspirado no modelo ELIZA, foi o Cybele (PRIMO and COELHO 2001). Posteriormente, foi desenvolvido o Elecktra, também em língua portuguesa, com aplicação voltada para a educação a distância (Leonhardt, Neisse, and Tarouco 2003). Em 2019, o processo de inscrição para o Exame Nacional do Ensino Médio (ENEM) foi disponibilizado por meio de uma interface conversacional baseada em chatbot (Figura 2.6).

O desenvolvimento de chatbots tem atraído investimentos de grandes corporações. Notavelmente, a IBM desenvolveu um sistema de resposta a perguntas em domínio aberto utilizando sua plataforma Watson (Ferrucci 2012). Esse tipo de tarefa representa um desafio computacional e de inteligência artificial (IA) considerável. Em 2011, o sistema baseado em Watson demonstrou sua capacidade ao competir e vencer competidores humanos no programa de perguntas e respostas JEOPARDY! (Ferrucci 2012).

Diversos outros chatbots foram desenvolvidos para atender a demandas específicas em variados domínios. Exemplos incluem: BUTI, um companheiro virtual com computação afetiva para auxiliar na manutenção da saúde cardiovascular (Junior 2008); EduBot, um agente conversacional projetado para a criação e desenvolvimento de ontologias com lógica de descrição (Lima 2017); PMKLE, um ambiente inteligente de aprendizado focado na educação em gerenciamento de projetos (Torreao 2005); RENAN, um sistema de diálogo inteligente fundamentado em lógica de descrição (Azevedo 2015); e MOrFEu, voltado para a mediação de atividades cooperativas em ambientes inteligentes na Web (Bada 2012).

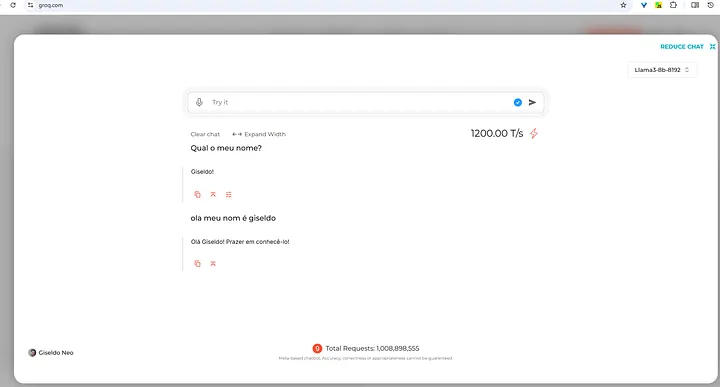

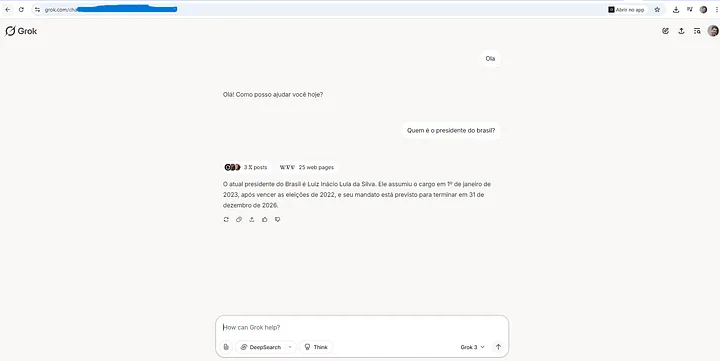

Entre os chatbots baseados em LLMs de destaque atualmente estão o Qwen https://chat.qwen.ai/, desenvolvido pela Alibaba, que se destaca por sua eficiência e suporte multilíngue; o DeepSeek https://chat.deepseek.com/, de código aberto voltado para pesquisa e aplicações empresariais com foco em precisão e escalabilidade; o Maritaca https://chat.maritaca.ai/, modelo brasileiro otimizado para o português; o Gemini https://gemini.google.com/, da Google, que integra capacidades multimodais e forte desempenho em tarefas diversas; o Mistralhttps://chat.mistral.ai/, da Mistral AI, que utiliza arquitetura de mistura de especialistas para maior eficiência; o Llama https://www.meta.ai/, da Meta, reconhecido por ser código aberto e ampla adoção na comunidade; o Claude https://claude.ai/, da Anthropic, projetado com ênfase em segurança e alinhamento ético, que vem ganhando adeptos para tarefas e codificação; e o Nemotron https://build.nvidia.com/models, da NVIDIA, que oferece modelos de linguagem otimizados para execução em GPUs e aplicações empresariais de alto desempenho. E o Groq https://grok.com/ da xAI.

Abordagens

Desde o pioneirismo do ELIZA, múltiplas abordagens e técnicas foram exploradas para o desenvolvimento de chatbots. Entre as mais relevantes, destacam-se: AIML com correspondência de padrões (pattern matching), análise sintática (Parsing), modelos de cadeia de Markov (Markov Chain Models), uso de ontologias, redes neurais recorrentes (RNNs), redes de memória de longo prazo (LSTMs), modelos neurais sequência-a-sequência (Sequence-to-Sequence), aprendizado adversarial para geração de diálogo, além de abordagens baseadas em recuperação (Retrieval-Based) e generativas (Generative-Based) (Borah et al. 2018; Ramesh et al. 2017; Shaikh et al. 2016; Abdul-Kader and Woods 2015; Li et al. 2018), entre outras.

A seguir, uma lista resumida das tecnologias e marcos da criação dos chatbots:

ELIZA: o primeiro chatbot, que utilizava correspondência de padrões simples para simular um psicoterapeuta. Foi um marco na história dos chatbots e influenciou o desenvolvimento de sistemas conversacionais subsequentes (Weizenbaum 1966).

AIML: Artificial Intelligence Markup Language, uma linguagem de marcação baseada em XML que deu origem ao ALICE (Richard S. Wallace 2000). Essa linguagem de marcação permite a definição de regras de correspondência de padrões (pattern matching) para mapear entradas do usuário a respostas predefinidas.

Transformers: arquitetura de rede neural baseada em atenção, que revolucionou o processamento de linguagem natural (NLP) (Vaswani et al. 2017). Modelos como BERT e GPT são exemplos de arquiteturas baseadas em Transformer que têm sido amplamente utilizadas em chatbots modernos.

GPT: Àdaptação do Transformer modelos de linguagem generativa, como o GPT-2, que utilizam redes neurais profundas para gerar texto coerente e relevante em resposta a entradas do usuário. Esses modelos são treinados em grandes quantidades de dados e podem ser adaptados para tarefas específicas, como atendimento ao cliente ou suporte técnico.

Além disso, diversos frameworks têm sido desenvolvidos para facilitar a criação desses agentes complexos, como CrewAI (CrewAI 2025) e Mangaba.AI (Mangaba AI 2025) e plataformas diversas como Hugging Face (e.g., Transformers Agents), que fornecem abstrações e ferramentas em Python para orquestrar múltiplos componentes e o uso de ferramentas externas.

Chatbot pensa?

Apesar do progresso recente de chatbots, o mecanismo fundamental da inteligência em nível humano, frequentemente refletido na comunicação, ainda não está totalmente esclarecido (Shum, He, and Li 2018). Para avançar na solução desses desafios, serão necessários progressos em diversas áreas da IA cognitiva, tais como: modelagem empática de conversas, modelagem de conhecimento e memória, inteligência de máquina interpretável e controlável, e calibração de recompensas emocionais (Shum, He, and Li 2018).

Uma das dificuldades na construção de chatbots do tipo orientado a tarefas - a exemplo do Artificial Intelligence Markup Language (AIML) usado no ALICE - reside em gerenciar a complexidade das estruturas condicionais (“se-então”) que definem o fluxo do diálogo (Raj 2019). Quanto maior o número de decisões a serem tomadas, mais complexas tendem a ser essas estruturas condicionais. Contudo, elas são essenciais para codificar fluxos de conversação complexos. Se a tarefa que o chatbot visa simular é inerentemente complexa e envolve múltiplas condições, o código precisará refletir essa complexidade. Para facilitar a visualização desses fluxos, uma solução eficaz é a utilização de fluxogramas. Embora simples de criar e entender, os fluxogramas constituem uma ferramenta visual de representação para este problema.

NOTA

Uma explicação detalhada do AIML será apresentada no Capítulo 3.

Os chatbots baseados em AIML apresentam desvantagens específicas. Por exemplo, o conhecimento é representado como instâncias de arquivos AIML. Se esse conhecimento for criado com base em dados coletados da Internet, ele não será atualizado automaticamente, exigindo atualizações periódicas manuais (Madhumitha, Keerthana, and Hemalatha 2015). No entanto, já existem abordagens para mitigar essa limitação, permitindo carregar conteúdo AIML a partir de fontes como arquivos XML (Macedo and Fusco 2014), um corpus textual (De Gasperis, Chiari, and Florio 2013) ou dados do Twitter (Yamaguchi, Mozgovoy, and Danielewicz-Betz 2018). Além de abordagens no-code que geram o AIML a partir de fluxogramas (G. S. Neo et al. 2023).

Outra desvantagem do AIML, a exemplo do Eliza, reside na relativa complexidade de seus padrões de correspondência (patterns). Além disso, a manutenção do sistema pode ser árdua, pois, embora a inserção de conteúdo (categorias) seja conceitualmente simples, grandes volumes de informação frequentemente precisam ser adicionados manualmente (Madhumitha, Keerthana, and Hemalatha 2015).

Especificamente no caso do AIML, a construção e a visualização de fluxos de diálogo complexos enfrentam dificuldades adicionais. Devido ao seu formato baseado em texto, muitas vezes é difícil perceber claramente como as diferentes categorias (unidades de conhecimento e resposta) se interligam para formar a estrutura da conversação.

O interesse pelos chatbots continua crescendo. No entanto, eles podem ser complicados para se construir e os usuários nem sempre têm experiência suficiente para configurá-los. Alguns usuários não têm necessariamente habilidades de programação ou de TI avançadas. Para que eles possam criar e personalizar os chatbots, é importante que a autoria seja fácil de usar e intuitiva. Ela não deve exigir conhecimento de linguagens de computador que sejam difíceis de entender para o público em geral. Para resolver esses problemas, várias ferramentas de autoria já foram propostas e podem ser utilizadas por usuários sem o uso de código, ferramentas no-code (Silva Neo et al. 2023).

Mesmo um chatbot baseado em LLM também não “pensa” no sentido cognitivo humano, mas opera a partir de um mecanismo estatístico de predição de tokens condicionado a um contexto. Sua forma de funcionamento é sustentada por arquiteturas neurais profundas, treinadas sobre grandes volumes de dados textuais, que capturam regularidades linguísticas, semânticas e pragmáticas. Assim, a resposta gerada resulta da estimativa da sequência de palavras mais provável dado um histórico de entrada, e não de um processo deliberativo consciente.

A aparente coerência e racionalidade observadas nas respostas decorrem da capacidade do modelo em representar padrões complexos da linguagem natural em espaços vetoriais de alta dimensão. Esses modelos internalizam relações sintáticas, semânticas e discursivas, permitindo generalização para contextos não vistos durante o treinamento. Dessa forma, o chatbot consegue simular comportamentos como argumentação, explicação e síntese, ainda que tais comportamentos sejam emergentes do ajuste estatístico e não de compreensão genuína.

A justificativa para esse modo de “pensar” reside na eficácia prática do paradigma. Ao invés de regras explícitas ou sistemas simbólicos rígidos, os LLMs oferecem flexibilidade, escalabilidade e adaptação a múltiplos domínios, o que os torna adequados para tarefas complexas de interação homem-máquina. A combinação de aprendizado profundo, atenção contextual e grandes corpora textuais permite ao chatbot responder de forma contextualizada, mantendo consistência local e global no discurso.

Por fim, é fundamental reconhecer as limitações inerentes a esse modelo de funcionamento. A ausência de intencionalidade, consciência e compreensão semântica profunda implica que o chatbot pode produzir respostas plausíveis, porém factualmente incorretas ou logicamente inconsistentes. Assim, a forma de “pensar” de um chatbot baseado em LLM deve ser entendida como um mecanismo probabilístico avançado de geração de linguagem, útil e poderoso, mas distinto do raciocínio humano.

Exercícios

Qual é o objetivo principal de um chatbot?

Substituir completamente os seres humanos no atendimento ao cliente.

Simular uma conversa humana para resolver problemas ou fornecer informações.

Gerar textos literários complexos.

Armazenar grandes quantidades de dados em tempo real.

Qual das seguintes opções descreve corretamente um benefício dos chatbots?

Eles nunca precisam ser atualizados.

Eles podem operar 24 horas por dia, 7 dias por semana, sem intervenção humana.

Eles sempre tomam decisões melhores do que humanos.

Eles substituem completamente a necessidade de suporte técnico.

Qual das opções a seguir é uma técnica comum usada por chatbots para entender o que o usuário está perguntando?

Mineração de Dados

Tokenização

Compressão de Dados

Balanceamento de Carga

Qual é o papel dos embeddings de palavras em chatbots?

Converter palavras em vetores numéricos que capturam o significado semântico.

Armazenar grandes quantidades de dados de conversação.

Executar algoritmos de compressão de texto.

Facilitar a tradução de texto entre diferentes idiomas.

Qual é a principal limitação dos chatbots baseados em regras?

Eles não conseguem operar em tempo real.

Eles exigem grandes quantidades de dados para funcionar.

Eles só podem responder a consultas específicas para as quais foram

programados.

Eles são incapazes de realizar tarefas repetitivas.

ELIZA e AIML

“Somos autómatos em três quartas partes das nossas ações.”

Wilhelm Leibniz

Objetivo Explorar o funcionamento do ELIZA, suas regras de transformação, implementação e legado histórico, evidenciando as bases dos sistemas conversacionais. Além de explicar a linguagem AIML, mostrando como ela possibilitou a construção de chatbots mais robustos e modulares.

Introdução

O chatbot ELIZA foi um marco histórico e um dos primeiros programas de processamento de linguagem natural e foi apresentado em 1966 por Joseph Weizenbaum no MIT (Weizenbaum 1966).

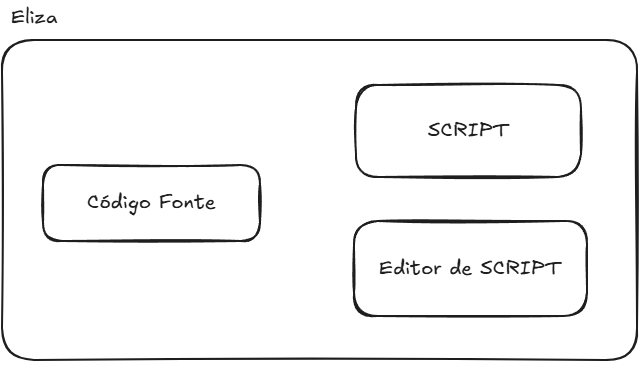

O conjunto de padrões e respostas predefinidas constitui o que Weizenbaum chamou de “roteiro” (ou script) de conversa. O mecanismo do ELIZA separa o motor de processamento dos dados, sendo o algoritmo de busca de palavras-chave e aplicação de regras, do script em si. Isso significa que ELIZA podia, em teoria, simular diferentes personalidades ou tópicos apenas carregando um script diferente, sem alterar o código do programa (veja na Figura 3.1). Também foi codificado um editor de texto para as alterações do próprio script.

Um destes roteiros, o script DOCTOR, deixou o ELIZA famoso. Com este script carregado, o ELIZA simulava precariamente um psicoterapeuta (do estilo Rogeriano), refletindo as palavras do usuário de volta em forma de pergunta.

Na lista abaixo é apresentado um exemplo de diálogo (retirado do artigo original) entre um usuário humano e ELIZA, mostrando as respostas em letras maiúsculas. Nesse exemplo, o usuário faz afirmações pessoais (“Men are all alike.”, “Well, my boyfriend made me come here.”) e ELIZA responde com perguntas ou reformulações (“IN WHAT WAY”, “YOUR BOYFRIEND MADE YOU COME HERE?”) reutilizando termos do próprio usuário. Esse estilo reflexivo encoraja o usuário a continuar falando sem fornecer respostas diretas.

Men are all alike.

IN WHAT WAY

They're always bugging us about something or other.

CAN YOU THINK OF A SPECIFIC EXAMPLE

Well, my boyfriend made me come here.

YOUR BOYFRIEND MADE YOU COME HERE

He says I'm depressed much of the time.

I AM SORRY TO HEAR YOU ARE DEPRESSED

It's true. I am unhappy.

DO YOU THINK COMING HERE WILL HELP YOU NOT TO BE UNHAPPY

I need some help, that much seems certain.

WHAT WOULD IT MEAN TO YOU IF YOU GOT SOME HELP

Perhaps I could learn to get along with my mother.

TELL ME MORE ABOUT YOUR FAMILY

My mother takes care of me.

WHO ELSE IN YOUR FAMILY TAKES CARE OF YOU

My father.

YOUR FATHER

You are like my father in some ways.

WHAT RESEMBLANCE DO YOU SEE

You are not very aggressive but I think you don't want me to

notice that.

WHAT MAKES YOU THINK I AM NOT VERY AGGRESSIVE

You don't argue with me.

WHY DO YOU THINK I DON'T ARGUE WITH YOU

You are afraid of me.

DOES IT PLEASE YOU TO BELIEVE I AM AFRAID OF YOU

My father is afraid of everybody.

WHAT ELSE COMES TO MIND WHEN YOU THINK OF YOUR FATHER

Bullies.

DOES THAT HAVE ANYTHING TO DO WITH THE FACT THAT YOUR BOYFRIEND MADE YOU COME HERE Processamento

O funcionamento do ELIZA baseia-se em correspondência de padrões por palavras-chave (Mittmann 2021). Técnica também chamada “casamento de padrão”, em inglês pattner matching, seu paradigma também se encaixa na técnica baseada em regras (ou rule-based). A cada turno do diálogo, o texto de entrada do usuário é analisado em busca de palavras-chave predefinidas. O ELIZA faz uma varredura da sentença da esquerda para a direita, identificando se alguma palavra correspondia a uma palavra-chave do script. Caso encontre uma palavra-chave no script, ELIZA empilha essa palavra até o final da frase. Depois, ele seleciona a palavra-chave mais “importante” até encontrar uma pontuação. Para isso, ele mantém uma lista de pesos associados a cada palavra-chave.

Por exemplo, o script DOCTOR definia palavras-chave como “ALIKE” ou “SAME” com alta prioridade; assim, na frase “Men are all alike.” o programa detectava a palavra “ALIKE” e disparava uma resposta associada a ela (no caso: “In what way?”). Se múltiplas palavras-chave aparecessem, ELIZA escolhia aquela de maior peso para formular a resposta.

Primeiro o texto de entrada digitado pelo usuário era separado em palavras, em uma técnica que hoje chamamos de tokenização de palavras, mas que ainda não existia na época. A palavra-chave era identificada, comparando-a sequencialmente até o fim das palavras existentes, ou até ser encontrada uma pontuação. Caso fosse encontrada uma pontuação (ponto final ou vírgula), o texto após a pontuação era ignorado se já tivesse sido identificada uma palavra-chave. Assim, cada processamento da resposta utiliza uma única frase do usuário. Se várias palavras-chave fossem encontradas antes da pontuação, a de maior peso era selecionada.

Por exemplo, o usuário entra com o texto: “I am sick. but, today is raining”. Se houvesse uma palavra-chave no script ranqueando a palavra “SICK” com alta prioridade, a entrada processada seria somente “I am sick”, o restante depois da pontuação (neste caso, o ponto) seria ignorado pelo programa.

Se nenhuma palavra-chave fosse encontrada na entrada, ELIZA recorria a frases genéricas programadas, chamadas de respostas vazias ou sem conteúdo. Nesses casos, o chatbot emitia mensagens do tipo “I see.” ou “Please, go on.”. Esse mecanismo evitava silêncio quando o usuário dizia algo fora do escopo do script.

Além disso, a implementação original incluía uma estrutura de memória: algumas declarações recentes do usuário eram armazenadas e, se uma entrada subsequente não contivesse novas keywords, ELIZA poderia recuperar um tópico anterior e introduzi-lo na conversa. Por exemplo, se o usuário mencionasse família (em inglês family) em um momento e depois fizesse uma afirmação vaga, o programa poderia responder retomando o assunto da família (“DOES THAT HAVE ANYTHING TO DO WITH YOUR FAMILY?”). Essa estratégia dava uma pseudo-continuidade ao diálogo, simulando que o sistema “lembrava” de informações fornecidas anteriormente.

Regras de Transformação

Encontrada a palavra-chave, ELIZA aplicava uma regra de transformação associada a ela para gerar a resposta. As regras são definidas em pares: um padrão de análise (decomposition rule) e um modelo de reconstrução de frase (reassembly rule).

Primeiro, a frase do usuário é decomposta conforme um padrão que identifica a contexto mínimo em torno da palavra-chave. Essa decomposição frequentemente envolve separar a frase em partes e reconhecer pronomes ou estruturas gramaticais relevantes. Por exemplo, considere a entrada “You are very helpful.”. Uma regra de decomposição pode identificar a estrutura “You are X” — onde “X” representa o restante da frase — e extrair o complemento “very helpful” como um componente separado.

Em seguida, a regra de reassembly correspondente é aplicada, remontando uma sentença de resposta em que “X” é inserido em um template pré-definido. No exemplo dado, o template de resposta poderia ser “What makes you think I am X?”; ao inserir X = “very helpful”, gera-se “What makes you think I am very helpful?”. Observe que há uma inversão de pessoa: o pronome “you” do usuário foi trocado por “I” na resposta do bot.

De fato, uma parte importante das transformações do ELIZA envolve substituir pronomes (eu/você, meu/seu) para que a resposta faça sentido como uma frase do ponto de vista do computador falando com o usuário. Esse algoritmo de substituição é relativamente simples (por exemplo, “meu” → “seu”, “eu” → “você”, etc.), mas é essencial para dar a impressão de entendimento gramatical.

Veja no código-fonte abaixo uma parte do conteúdo do arquivo DOCTOR adaptado. A primeira linha REMEMBER 5 estabelece que a prioridade da palavra REMEMBER é 5, caso o usuário entre com uma frase com a palavra REMEMBER, o ELIZA irá responder com uma das perguntas definidas nos parênteses, dentro do nível da palavra REMEMBER. A segunda lista dentro do REMEMBER são as regras de transformação de frases (chamadas de decomposition rule e reassembly rule) associadas à palavra-chave REMEMBER. O mesmo se repete para a palavra IF que tem um peso diferente de REMEMBER.

(REMEMBER 5

(

(0 YOU REMEMBER 0)

(DO YOU OFTEN THINK OF 4)

(DOES THINKING OF ~ BRING ANYTHING ELSE TO MINO)

(WHAT ELSE OO YOU REMEMBER)

(WHY DO YOU REMEMBER 4 JUST NOW)

(WHAT IN THE PRESENT SITUATION REMINDS YOU OF 4)

(WHAT IS THE CONNECTION BETWEEN ME AND 4)

)

(

(0 DO I REMEMBER 0)

(DID YOU THINK I WOULD FORGET 5)

(WHY DO YOU THINK I SHOULD RECALL 5 NOW)

(WHAT ABOUT 5)

(=WHAT)

(YOU MENTIONED S)

)

)

(IF 3

(

(0 IF 0)

(DO YOU THINK ITS LIKELY THAT 3)

(DO YOU WISH THAT 3)

(WHAT DO YOU THINK ABOUT 3)

(REALLY, 2 3)

)

)Implementação e Variações

A implementação original de ELIZA foi feita em uma linguagem chamada MAD-SLIP (um dialeto de Lisp) rodando em um mainframe IBM 7094 no sistema CTSS do MIT. O código-fonte do programa principal continha o mecanismo de correspondência, enquanto as regras de conversação (script DOCTOR) eram fornecidas separadamente em formato de listas associativas, similar a uma lista em Lisp. Infelizmente, Weizenbaum não publicou o código completo no artigo de 1966 (o que era comum na época), mas décadas depois o código em MAD-SLIP foi recuperado nos arquivos do MIT, comprovando os detalhes de implementação (Lane et al. 2025). De qualquer forma, a arquitetura descrita no artigo influenciou inúmeras reimplementações acadêmicas e didáticas nos anos seguintes.

Diversos entusiastas e pesquisadores reescreveram ELIZA em outras linguagens de programação, dada a simplicidade relativa de seu algoritmo. Ao longo dos anos, surgiram versões em Lisp, PL/I, BASIC, Pascal, Prolog, Java, Python, OZ, JavaScript, entre muitas outras. Cada versão normalmente incluía o mesmo conjunto de regras do script terapeuta ou pequenas variações.

As ideias de ELIZA também inspiraram chatbots mais avançados. Poucos anos depois, em 1972, surgiu PARRY, escrito pelo psiquiatra Kenneth Colby, que simulava um paciente paranoico. PARRY tinha um modelo interno de estado emocional e atitudes, mas na camada de linguagem ainda usava muitas respostas baseadas em regras, chegando a “conversar” com o próprio ELIZA em experimentos da época.

Em 1995, Richard Wallace desenvolveu o chatbot ALICE (Artificial Linguistic Internet Computer Entity), que levava o paradigma de ELIZA a uma escala muito maior. ALICE utilizava um formato XML chamado AIML (Artificial Intelligence Markup Language) para definir milhares de categorias de padrões e respostas. Com mais de 16.000 templates mapeando entradas para saídas (Richard S. Wallace 2000), ALICE conseguia manter diálogos bem mais naturais e abrangentes que o ELIZA original, embora o princípio básico de correspondência de padrões permanecesse. Esse avanço rendeu a ALICE três vitórias no Prêmio Loebner (competição de chatbots) no início dos anos 2000 (Richard S. Wallace 2000).

Outras variações e sucessores notáveis incluem Jabberwacky (1988) – que já aprendia novas frases – e uma profusão de assistentes virtuais e bots de domínio específico nas décadas seguintes (Richard S. Wallace 2000). Em suma, o legado de ELIZA perdurou por meio de inúmeros chatbots baseados em regras, até a transição para abordagens estatísticas e de aprendizado de máquina no final do século XX.

Mecanismo de Pesos

A técnica de ELIZA, baseada em palavras-chave com respostas predefinidas, contrasta fortemente com os métodos de Modelos de Linguagem Grande (LLMs) atuais, como o Generative Pre-trained Transformer (GPT), que utilizam redes neurais de milhões (ou trilhões) de parâmetros e mecanismos de atenção. Mais detalhes sobre LLM no Capítulo 5.

No ELIZA, a “importância” de uma palavra era determinada manualmente pelo programador através de pesos ou rankings atribuídos a certas palavras-chave no script. Ou seja, o programa não aprendia quais termos focar – ele seguia uma lista fixa de gatilhos. Por exemplo, termos como “sempre” ou “igual” tinham prioridade alta no script DOCTOR para garantir respostas apropriadas.

Em contraste, modelos modernos como o GPT não possuem uma lista fixa de palavras importantes; em vez disso, eles utilizam o mecanismo de self-attention para calcular dinamicamente pesos entre todas as palavras da entrada conforme o contexto (Vaswani et al. 2017).

Na arquitetura Transformer, cada palavra (na prática não é uma palavra e sim um token) de entrada gera consultas e chaves que interagem com todas as outras, permitindo ao modelo atribuir pesos maiores às palavras mais relevantes daquela frase ou parágrafo (Vaswani et al. 2017). Em outras palavras, o modelo aprende sozinho quais termos ou sequências devem receber mais atenção para produzir a próxima palavra na resposta. Esse mecanismo de atenção captura dependências de longo alcance e nuances contextuais que um sistema de palavras-chave fixas como o ELIZA não consegue representar.

Além disso, o “vocabulário” efetivo de um LLM é imenso – um modelo GPT pode ser treinado com trilhões de palavras e ter ajustado seus parâmetros para modelar estatisticamente a linguagem humana (Vaswani et al. 2017). Como resultado, pode-se dizer metaforicamente que os LLMs têm uma lista de “palavras-chave” milhões de vezes maior (na prática, distribuída em vetores contínuos) e um método bem mais sofisticado de calcular respostas do que o ELIZA.

Enquanto ELIZA dependia de coincidências exatas de termos para disparar regras, modelos como GPT avaliam similaridades semânticas e contexto histórico graças às representações densas (embeddings) aprendidas durante o treinamento de rede neural.

Geração de Texto

Devido à sua abordagem baseada em regras locais, o ELIZA tinha capacidade de contextualização muito limitada. Cada input do usuário era tratado quase isoladamente: o programa não construía uma representação acumulada da conversa, além de artifícios simples como repetir algo mencionado (a estrutura de memória) ou usar pronomes para manter a ilusão de continuidade. Se o usuário mudasse de tópico abruptamente, o ELIZA não “perceberia” – ele apenas buscaria a próxima palavra-chave disponível ou recorreria a frases genéricas.

Em contraste, modelos de linguagem modernos levam em conta um longo histórico de diálogo. Chatbots que usam GPT podem manter um contexto de centenas ou milhares de tokens (palavras ou fragmentos) em sua janela de atenção, o que significa que eles conseguem referenciar informações mencionadas vários parágrafos atrás e integrá-las na resposta corrente. O mecanismo de self-attention, em particular, permite que o modelo incorpore relações contextuais complexas: cada palavra gerada pode considerar influências de palavras distantes no texto de entrada (Vaswani et al. 2017).

Por exemplo, ao conversar com um LLM, se você mencionar no início da conversa que tem um irmão chamado Alex e depois perguntar “ele pode me ajudar com o problema?”, o modelo entenderá que “ele” se refere ao Alex mencionado anteriormente (desde que dentro da janela de contexto). Já o ELIZA original não teria como fazer essa ligação, a menos que houvesse uma regra explícita para “ele” e algum armazenamento específico do nome – algo impraticável de antecipar via regras fixas para todos os casos.

Outra diferença está na geração de linguagem. O ELIZA não gera texto original no sentido pleno: suas respostas são em grande parte frases prontas (ou templates fixos) embaralhadas com partes da fala do usuário. Assim, seu vocabulário e estilo são limitados pelo script escrito manualmente. Modelos GPT, por sua vez, geram respostas novas combinando probabilisticamente o conhecimento adquirido de um extenso corpus. Eles não se restringem a repetir trechos da entrada, podendo elaborar explicações, fazer analogias, criar perguntas coerentes com os exemplos linguísticos em sua base de treinamento. Enquanto ELIZA tendia a responder com perguntas genéricas ou devolvendo as palavras do usuário, os LLMs podem produzir respostas informativas e detalhadas sobre o assunto (pois “aprenderam” uma ampla gama de tópicos durante o treinamento). Por exemplo, se perguntarmos algo factual ou complexo, o ELIZA falharia por não ter nenhuma regra a respeito, provavelmente dando uma resposta vazia. Já um modelo como GPT tentará formular uma resposta baseada em padrões linguísticos aprendidos e em conhecimento implícito dos dados, muitas vezes fornecendo detalhes relevantes.

Em termos de fluência e variedade, os modelos modernos superam o ELIZA amplamente. O ELIZA frequentemente se repetia ou caía em loops verbais quando confrontado com inputs fora do roteiro – um limite claro de sistemas por regras estáticas. Os LLMs produzem linguagem muito mais natural e adaptável, a ponto de muitas vezes enganarem os usuários sobre estarem conversando com uma máquina (um efeito buscado desde o Teste de Turing). Ironicamente, ELIZA nos anos 60 já provocou um precursor desse fenômeno – o chamado Efeito ELIZA, em que pessoas atribuem compreensão ou sentimentos a respostas de computador que, na verdade, são superficiais. Hoje, em chatbots GPT, esse efeito se intensifica pela qualidade das respostas, mas a distinção fundamental permanece: ELIZA seguia scripts sem compreender, enquanto LLMs inferem padrões e significados de forma estatística, sem entendimento consciente, mas atingindo resultados que simulam compreensão de maneira muito mais convincente.

Em resumo, os avanços de arquitetura (especialmente o mecanismo de atenção) ampliaram drasticamente a capacidade de contextualização e geração dos chatbots modernos, marcando uma evolução significativa desde o mecanismo simples, porém pioneiro, de ELIZA.

ELIZA em Python

A seguir o código-fonte de um programa que retorna o que o usuário digitou na linguagem de programação Python, inspirado no paradigma ELIZA.

# método que processa a entrada do usuário

def response(user_input):

return "Você disse: " + user_input

# Exemplo de uso

user_input = "Eu estou feliz"

print("Você: {}".format(user_input))

print("Eliza: {}".format(response(user_input)))

user_input = "Eu estou alegre"

print("Você: {}".format(user_input))

print("Eliza: {}".format(response(user_input)))Você: Eu estou feliz

Eliza: Você disse: Eu estou feliz

Você: Eu estou alegre

Eliza: Você disse: Eu estou alegreEste código acima simplesmente repete o que o usuário digita. Ele define a função response, que retorna a string “Você disse: ” concatenada ao texto recebido.

Logo abaixo uma implementação um pouco mais robusta de um chatbot inspirado no paradigma ELIZA. Esta implementação demonstra a utilização de expressões regulares - mais sobre expressões regulares no Capítulo 4 - para a identificação de padrões textuais (palavras-chave) na entrada fornecida pelo usuário e a subsequente geração de respostas, fundamentada em regras de transformação predefinidas manualmente.

import re

import random

regras = [

(re.compile(r'\b(hello|hi|hey)\b', re.IGNORECASE),

["Hello. How do you do. Please tell me your problem."]), # regra 1

(re.compile(r'\b(I am|I\'?m) (.+)', re.IGNORECASE), # regra 2

["How long have you been {1}?",

"Why do you think you are {1}?"]),

(re.compile(r'\bI need (.+)', re.IGNORECASE), # regra 3

["Why do you need {1}?",

"Would it really help you to get {1}?"]),

(re.compile(r'\bI can\'?t (.+)', re.IGNORECASE), # regra 4

["What makes you think you can't {1}?",

"Have you tried {1}?"]),

(re.compile(r'\bmy (mother|father|mom|dad)\b', re.IGNORECASE), # regra 5

["Tell me more about your family.",

"How do you feel about your parents?"]),

(re.compile(r'\b(sorry)\b', re.IGNORECASE), # regra 6

["Please don't apologize."]),

(re.compile(r'\b(maybe|perhaps)\b', re.IGNORECASE), # regra 7

["You don't seem certain."]),

(re.compile(r'\bbecause\b', re.IGNORECASE), # regra 8

["Is that the real reason?"]),

(re.compile(r'\b(are you|do you) (.+)\?$', re.IGNORECASE), # regra 9

["Why do you ask that?"]),

(re.compile(r'\bcomputer\b', re.IGNORECASE), # regra 10

["Do computers worry you?"]),

]

respostas_padrao = [

"I see.",

"Please tell me more.",

"Can you elaborate on that?"

]

def response(entrada_usuario):

for padrao, respostas in regras:

match = padrao.search( entrada_usuario)

if match:

resposta = random.choice(respostas)

if match.groups():

resposta = resposta.format( *match.groups())

return resposta

return random.choice(respostas_padrao)

print("User: Hello.")

print("Bot: " + response("Hello."))

print("User: I am feeling sad.")

print("Bot: " + response("I am feeling sad."))

print("Maybe I was not good enough.")

print("Bot: " + response("Maybe I was not good enough."))

print("My mother tried to help.")

print("Bot: " + response("My mother tried to help."))User: Hello.

Bot: Hello. How do you do. Please tell me your problem.

User: I am feeling sad.

Bot: How long have you been feeling sad.?

Maybe I was not good enough.

Bot: You don't seem certain.

My mother tried to help.

Bot: How do you feel about your parents?Na implementação anterior, são definidos múltiplos padrões de

expressões regulares que correspondem a palavras-chave ou

estruturas frasais de interesse (e.g., saudações, construções como

“I am” ou “I need”, referências a termos familiares). A função

response, ao receber uma string de entrada, itera

sequencialmente sobre essas regras.

Quando uma correspondência (match) é encontrada, uma

resposta associada à regra é selecionada. É relevante notar que

diversas respostas predefinidas contêm marcadores

(placeholders), como {1}. Estes marcadores

são dinamicamente substituídos pelo conteúdo dos grupos capturados

pela expressão regular (mais detalhes sobre expressão regular no

Capítulo 4 na entrada original do usuário).

Por exemplo, se a entrada for “I am sad” e esta

corresponder a um padrão como r“I am (.*)”, o grupo

capturado ((.*)) conterá a string “sad”. Se

a resposta associada for “Why do you think you are {1}?”,

o sistema a formatará como “Why do you think you are

sad?”, substituindo {1} pelo conteúdo do

primeiro grupo capturado. Na ausência de correspondência com

qualquer regra específica, o sistema seleciona aleatoriamente uma

resposta genérica a partir de um conjunto predefinido (denominado,

por exemplo, respostas_padrao), tal como “I

see.”.

Usuário: Hello

Bot: Hello. How do you do. Please tell me your problem.

Usuário: I am feeling sad

Bot: Why do you think you are feeling sad?

Usuário: Because I lost my job

Bot: Is that the real reason?

Usuário: Maybe I was not good enough.

Bot: You don't seem certain.

Usuário: My mother tried to help.

Bot: Tell me more about your family.Observa-se na interação que o chatbot inicialmente respondeu à saudação (“Hello...”) com base na regra 1. Em seguida, a entrada “I am sad” ativou a regra 2, resultando em uma resposta que incorpora o termo “sad”. A interação prossegue com o sistema respondendo a entradas iniciadas por “Because...” (regra 8) e “Maybe...” (regra 7), entre outras. Cada resposta gerada foi determinada pela regra correspondente ativada e pelo conteúdo específico da sentença do usuário, mimetizando o comportamento baseado em padrões do sistema ELIZA original (Abdul-Kader and Woods 2015).

ELIZA com Python e Gradio

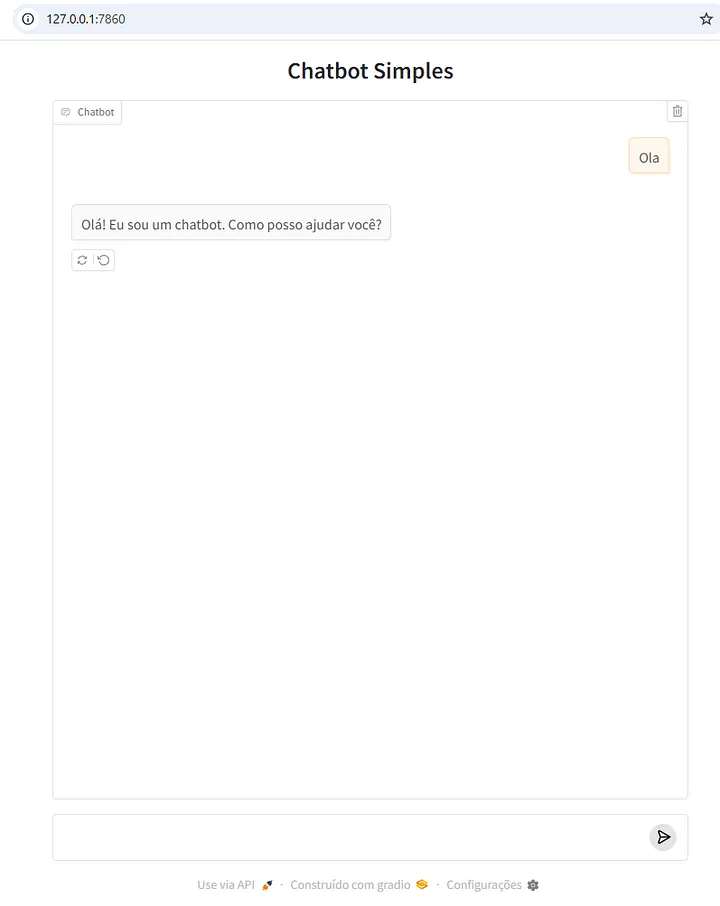

Nesta seção, vamos explorar como criar um chatbot usando a biblioteca Gradio e Python.

O Gradio é uma biblioteca de código aberto que permite criar interfaces de usuário para modelos de machine learning de forma rápida e fácil. Com Gradio, você pode criar aplicativos web interativos para visualizar e testar seus modelos, sem precisar de conhecimentos em frontend ou backend.

Antes de começar, certifique-se de ter o Python e o pip instalados em sua máquina. Em seguida, instale a biblioteca Gradio usando o comando:

pip install gradioÀ seguir está um exemplo básico de como criar um chatbot com Gradio e Python:

import gradio as gr

def chatbot(message, history):

resposta = "Olá! Eu sou um chatbot. Como posso ajudar você?"

return resposta

demo = gr.ChatInterface(

fn=chatbot,

title="Chatbot Simples"

)

demo.launch()Este código define uma função chatbot que processa o texto de entrada e retorna uma resposta. Em seguida, cria uma interface do chatbot usando a biblioteca Gradio, com um campo de texto para entrada e outro para saída.

Execute o chatbot: Salve o arquivo e, no terminal, navegue até o diretório onde ele está salvo. Digite:

python chatbot.pyVocê verá um link local (algo como http://127.0.0.1:7860). Clique nele ou copie e cole no navegador. Uma interface simples aparecerá com um campo de texto. Experimente digitar “olá” ou “tchau” e veja as respostas. Veja na Figura 3.2 um print da tela do chatbot já em execução.

Adicionando Lógica ao Chatbot: Agora que você tem uma interface básica, é hora de adicionar lógica ao chatbot. Você pode fazer isso adicionando condições e processamento de texto à função chatbot. Por exemplo:

# pip install gradio

import gradio as gr

def chatbot(message, history):

if "Olá" in message:

resposta = "Olá! Eu sou um chatbot. Como posso ajudar você?"

elif "Quem é você?" in message:

resposta = "Eu sou um chatbot criado para ajudar você com suas perguntas."

else:

resposta = "Desculpe, não entendi sua pergunta. Pode tentar novamente?"

return resposta

demo = gr.ChatInterface(

fn=chatbot,

title="Chatbot Simples"

)

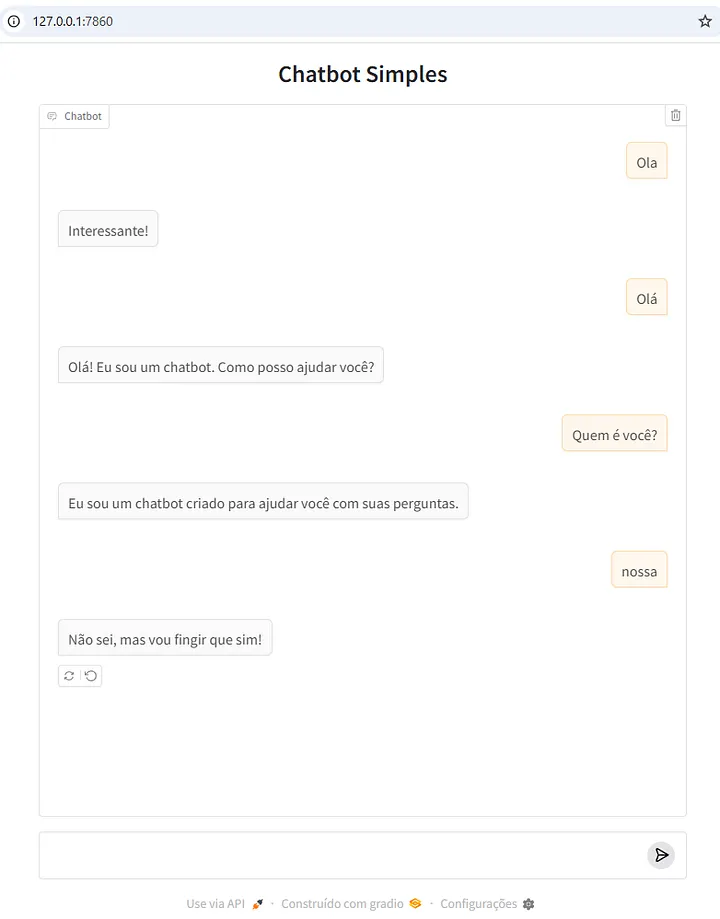

demo.launch()Na Figura 3.3 é possível visualizar o print da tela de um chatbot que responde de forma aleatória. Logo abaixo, o código-fonte que deu origem ao chatbot.

# pip install gradio

import gradio as gr

import random

def chatbot(message, history):

respostas = ["Interessante!", "Hmm, me conte mais!", "Não sei, mas vou fingir que sim!"]

if "Olá" in message:

resposta = "Olá! Eu sou um chatbot. Como posso ajudar você?"

elif "Quem é você?" in message:

resposta = "Eu sou um chatbot criado para ajudar você com suas perguntas."

else:

resposta = random.choice(respostas)

return resposta

demo = gr.ChatInterface(

fn=chatbot,

title="Chatbot Simples"

)

demo.launch()

Criar um chatbot com Gradio e Python é uma tarefa relativamente simples e rápida. Com essa biblioteca, você pode criar interfaces de usuário interativas para seus modelos de aprendizagem de máquina e criar chatbots para automação de tarefas ou suporte ao cliente. Este é apenas um exemplo básico, e você pode adicionar mais lógica e funcionalidades ao seu chatbot para torná-lo mais útil.

Artificial Intelligence Markup Language (AIML)

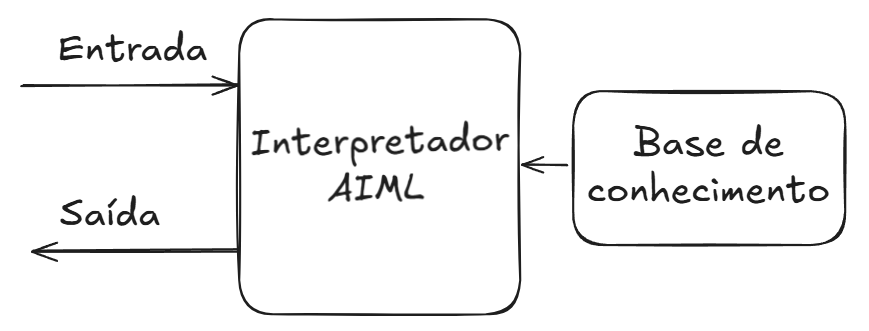

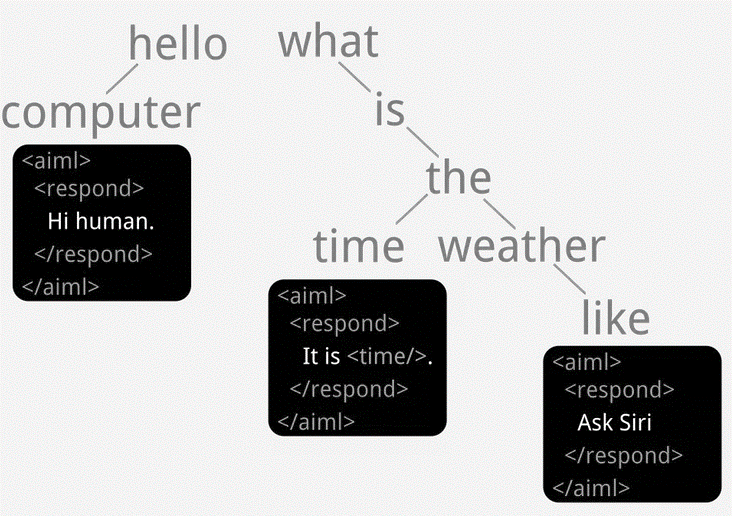

Décadas depois do Eliza, as técnicas de programação avançaram, surgiu a web e as linguagens de marcação como o HTML ganharam tração. É neste cenário que é criado o Artificial Intelligence Markup Language (AIML), uma especificação baseada em XML, proposta por Richard S. Wallace (2009), destinada à programação de chatbots. A concepção da linguagem prioriza o minimalismo, característica que simplifica o processo de criação de bases de conhecimento por indivíduos sem experiência prévia em programação (Richard S. Wallace 2009). A arquitetura fundamental de um interpretador AIML genérico é ilustrada na Figura 3.4.

Adaptado de (A. C. da Silva and Costa 2007)

A técnica central empregada pelo AIML é a correspondência de padrões (pattern matching). Este método é amplamente utilizado no desenvolvimento de chatbots, particularmente em sistemas orientados a perguntas e respostas (Abdul-Kader and Woods 2015). Uma das metas de projeto do AIML é possibilitar a fusão de bases de conhecimento de múltiplos chatbots especializados em domínios distintos. Teoricamente, um interpretador poderia agregar essas bases, eliminando automaticamente categorias redundantes para formar um chatbot mais abrangente (Richard S. Wallace 2000).

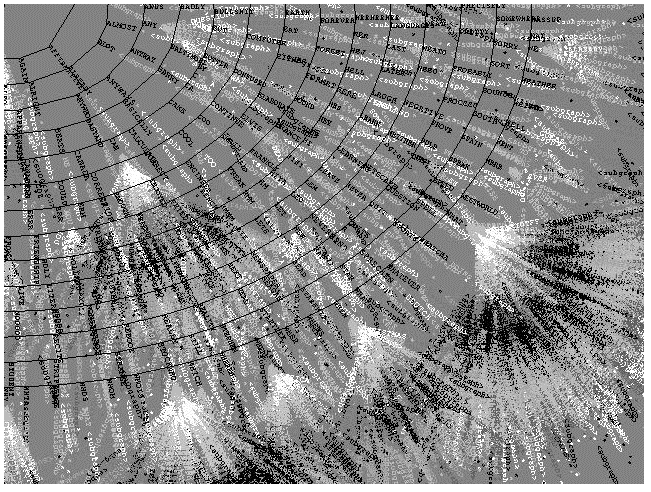

AIML é frequentemente associado aos chatbots de terceira geração (Maria et al. 2010) e estima-se sua adoção em mais de 50.000 implementações em diversos idiomas. Extensões da linguagem foram propostas, como o iAIML, que introduziu novas tags e incorporou o conceito de intenção com base nos princípios da Teoria da Análise da Conversação (Neves and Barros 2005). Adicionalmente, ferramentas baseadas na Web foram desenvolvidas para apoiar a construção de bases de conhecimento AIML (Krassmann et al. 2017). Um exemplo proeminente é o chatbot ALICE, cuja implementação em AIML compreendia aproximadamente 16.000 categorias, cada uma potencialmente contendo múltiplas tags XML aninhadas (Richard S. Wallace 2000). Uma representação visual desta estrutura de conhecimento é apresentada na Figura 3.5.

Retirado de (R. Wallace 2003)

Richard S. Wallace (2000) estabeleceu analogias entre o funcionamento de interpretadores AIML e a teoria do Raciocínio Baseado em Casos (RBC). Nessa perspectiva, as categorias AIML funcionam como “casos”, onde o algoritmo identifica o padrão que melhor se alinha à entrada do usuário. Cada categoria estabelece um vínculo direto entre um padrão de estímulo e um modelo de resposta. Consequentemente, chatbots AIML inserem-se na tradição da robótica minimalista, reativa ou de estímulo-resposta (Richard S. Wallace 2000), conforme esquematizado na Figura 3.6. Vale notar que a própria técnica de RBC já foi integrada a interpretadores AIML como um mecanismo para consultar fontes de dados externas e expandir a base de conhecimento do agente (Kraus and Fernandes 2008).

Retirado de (Lima 2017).

Os chatbots que utilizam AIML são classificados como sistemas “baseados em recuperação” (retrieval-based). Tais modelos operam a partir de um repositório de respostas predefinidas, selecionando a mais apropriada com base na entrada do usuário e no contexto conversacional, guiando assim o fluxo da interação. Esta abordagem é frequentemente empregada na construção de chatbots destinados a operar em domínios de conhecimento restritos (Borah et al. 2018).

O código-fonte à seguir, demonstra a estrutura elementar de um

arquivo AIML. A tag <category>

encapsula a unidade básica de conhecimento. Internamente, a

tag <pattern> define o padrão de

entrada a ser reconhecido (no exemplo, o caractere curinga

*, que corresponde a qualquer entrada), enquanto a

tag <template> contém a resposta

associada. No exemplo ilustrado, o chatbot responderia

“Hello!” a qualquer interação. Uma visão abstrata da árvore de

conhecimento resultante pode ser observada logo abaixo. O AIML

padrão suporta transições baseadas primariamente em

correspondência de padrões, uma limitação inerente, embora

extensões específicas de interpretadores possam permitir a

integração de outras técnicas de processamento.

<aiml>

<category>

<pattern>*</pattern>

<template>Hello!</template>

</category>

</aiml>

Retirado de https://www.pandorabots.com/docs/aiml-fundamentals/

O profissional responsável pela criação, manutenção e curadoria da base de conhecimento de um chatbot AIML é denominado botmaster (Richard S. Wallace 2000). Suas atribuições englobam a edição da base (frequentemente via ferramentas auxiliares), a análise de logs de diálogo para identificar padrões de interação e a subsequente criação ou refino de respostas. Este papel pode ser exercido por indivíduos com diferentes perfis, incluindo webmasters, desenvolvedores, redatores, engenheiros ou outros interessados na construção de chatbots (Richard S. Wallace 2000).

Algumas implementações de interpretadores AIML podem incorporar capacidades rudimentares de compreensão semântica através do Resource Description Framework (RDF)1. O RDF é um padrão W3C para representação de informações na Web, usualmente por meio de triplas (sujeito-predicado-objeto) que descrevem relações entre entidades. No contexto AIML, RDF pode ser utilizado para armazenar e consultar fatos. Contudo, mesmo com tais adições, as capacidades linguísticas permanecem aquém da complexidade e do potencial gerativo da linguagem humana, conforme descrito por Chomsky and Lightfoot (2002).

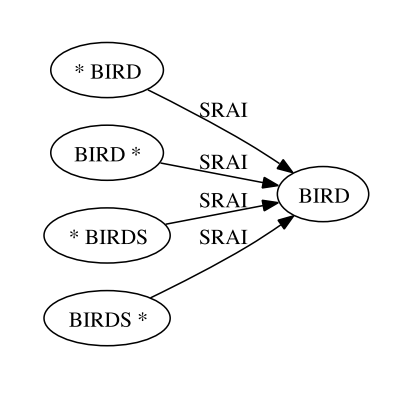

Embora Höhn

(2019) argumente que o AIML padrão carece de um conceito

explícito de “intenção” (intent), similar ao encontrado

em plataformas de Natural Language Understanding (NLU), é

possível emular o reconhecimento de intenções. Isso é tipicamente

alcançado definindo categorias que representam “formas canônicas”

ou “padrões atômicos” para uma intenção específica2. Variações de entrada (e.g.,

“oi”, “olá”) podem ser mapeadas para uma categoria canônica (e.g.,

“saudação”) usando a tag <srai>

(Symbolic Reduction Artificial Intelligence), que

redireciona o fluxo de processamento (ver Figura 3.8). Dessa forma, um

chatbot AIML pode gerenciar intenções distintas dentro de

seu domínio, como realizar um pedido ou verificar o status de

entrega.

<srai>.Retirado de (De Gasperis, Chiari, and Florio 2013)

Os chatbots baseados em AIML têm obtido sucesso significativo em competições como o Prêmio Loebner. Notavelmente, o chatbot Mitsuku3, desenvolvido por Steve Worswick, conquistou múltiplos títulos 4, seguindo vitórias anteriores do ALICE (Richard S. Wallace 2000).

Adicionalmente, Mitsuku foi classificado em primeiro lugar numa análise comparativa envolvendo oito chatbots (Sharma, Verma, and Sahni 2020). Nesse estudo, que avaliou atributos conversacionais com base em um conjunto padronizado de perguntas, o Google Assistant obteve a segunda posição, seguido pela Siri em terceiro. O chatbot ALICE alcançou a quarta posição, enquanto o ELIZA ficou na última colocação entre os sistemas comparados (Sharma, Verma, and Sahni 2020).

Tags do AIML

Esta seção descreve as principais tags do AIML, versão 1.0.

<aiml>

No contexto de AIML (Artificial Intelligence Markup Language), a tag <aiml> é usada para definir o início de um documento AIML que contém os padrões e respostas que um motor de chatbot deve usar. Ela envolve todo o documento, indicando que o conteúdo entre as tags <aiml> é escrito em AIML.

<aiml version="1.0">

<!-- Categorias aqui -->

</aiml><category>

Descrição: Unidade básica de conhecimento, contendo um padrão e uma resposta.

<category>

<pattern>OLÁ</pattern>

<template>Oi! Como posso ajudar você hoje?</template>

</category><pattern>

Descrição: Define o padrão de entrada do

usuário, com curingas como * e _.

<category>

<pattern>EU GOSTO DE *</pattern>

<template>Que bom que você gosta de <star/>!</template>

</category><template>

Descrição: Define a resposta do bot ao padrão correspondente.

<category>

<pattern>QUAL É O SEU NOME</pattern>

<template>Meu nome é neo chatbot.</template>

</category> <star/>

Descrição: Captura o conteúdo do curinga

* ou _.

<category>

<pattern>MEU NOME É *</pattern>

<template>Olá, <star/>!</template>

</category><that>

Descrição: Considera a última resposta do bot para decidir a próxima.

<category>

<pattern>SIM</pattern>

<that>Você gosta de programar?</that>

<template>Ótimo! Qual linguagem você prefere?</template>

</category><topic>

Descrição: Define um contexto ou tópico para categorias.

<category>

<pattern>VAMOS FALAR SOBRE ESPORTE</pattern>

<template>Ok! <topic name="esporte"/></template>

</category><random> e

<li>

Descrição: Escolhe aleatoriamente uma resposta de uma lista.

<category>

<pattern>COMO ESTÁ O TEMPO</pattern>

<template>

<random>

<li>Está ensolarado!</li>

<li>Está chovendo.</li>

</random>

</template>

</category><condition>

Descrição: Adiciona lógica condicional baseada em variáveis.

<category>

<pattern>COMO EU ESTOU</pattern>

<template>

<condition name="humor">

<li value="feliz">Você está bem!</li>

<li>Não sei ainda!</li>

</condition>

</template>

</category><set> e

<get>

Descrição: Define e recupera variáveis.

<category>

<pattern>MEU NOME É *</pattern>

<template>

<set name="nome"><star/></set>Olá, <get name="nome"/>!

</template>

</category><srai>

Descrição: Redireciona a entrada para outro padrão.

<category>

<pattern>OI</pattern>

<template><srai>OLÁ</srai></template>

</category><think>

Descrição: Executa ações sem exibir o conteúdo.

<category>

<pattern>EU SOU TRISTE</pattern>

<template>

<think><set name="humor">triste</set></think>Sinto muito!

</template>

</category><person>,

<person2>, <gender>

Descrição: Transforma pronomes ou ajusta gênero.

<category>

<pattern>EU TE AMO</pattern>

<template><person><star/></person> ama você também!</template>

</category><formal>,

<uppercase>,

<lowercase>

Descrição: Formata texto (capitaliza, maiúsculas, minúsculas).

<category>

<pattern>MEU NOME É joão</pattern>

<template>Olá, <formal><star/></formal>!</template>

</category><sentence>

Descrição: Formata como frase (primeira letra maiúscula, ponto final).

<category>

<pattern>oi</pattern>

<template><sentence><star/></sentence></template>

</category>Exemplo em Python

A seguir um exemplo do uso de um interpretador AIML em Python. O arquivo “cerebro.aiml” deve existir anteriormente. Use uma versão compatível com a biblioteca aiml que é somente compatível com versões antigas do Python, do Python 3.6 para trás, ou seja, não funciona no Python 3.12.

# pip install aiml

import aiml

# Criar kernel (núcleo do bot)

kernel = aiml.Kernel()

cerebro_aiml_text = """

<aiml version="1.0.1" encoding="UTF-8">

<category>

<pattern>OI</pattern>

<template>Olá! Como posso ajudar você?</template>

</category>

<category>

<pattern>OBRIGADO</pattern>

<template>De nada!</template>

</category>

</aiml>

"""

# Salvar o conteúdo AIML em um arquivo

with open("cerebro.aiml", "w", encoding="utf-8") as f:

f.write(cerebro_aiml_text)

# Carregar o arquivo AIML

kernel.learn("cerebro.aiml")

# Loop de conversa

while True:

user_input = input("Você: ")

if user_input.lower() in ["sair", "exit", "quit"]:

break

response = kernel.respond(user_input)

print("Bot:", response)Você: oi

Bot: Olá! Como posso ajudar você?O arquivo std-startup.xml é um ponto de partida e geralmente carrega outros arquivos .aiml.

<aiml version="1.0.1" encoding="UTF-8">

<category>

<pattern>OI</pattern>

<template>Olá! Como posso te ajudar?</template>

</category>

<category>

<pattern>QUAL SEU NOME</pattern>

<template>Eu sou um chatbot em AIML.</template>

</category>

</aiml>Exercícios

Assinale a alternativa que melhor descreve a principal diferença entre um chatbot conversacional e um chatbot orientado a tarefas:

O chatbot conversacional utiliza apenas regras, enquanto o orientado a tarefas utiliza apenas redes neurais.

O chatbot conversacional busca manter diálogo aberto, enquanto o orientado a tarefas segue fluxos específicos para executar ações.

Chatbots orientados a tarefas não podem utilizar linguagem natural.

Chatbots conversacionais não podem responder perguntas sobre assuntos gerais.

Sobre o ELIZA, marque a alternativa correta:

Utilizava redes neurais profundas e mecanismos de autoatenção.

Interpretava semanticamente as frases do usuário com compreensão profunda.

Baseava-se em regras simples e padrões para reformular entradas do usuário.

Possuía memória de longo prazo para manter contexto amplo de conversa.

A arquitetura Transformers, introduzida em 2017, é caracterizada principalmente por:

Utilizar sequências fixas de regras pré-programadas.

Empregar mecanismos de autoatenção para avaliar relações entre palavras.

Substituir completamente qualquer forma de treinamento com dados.

Impedir o uso de modelos generativos em tarefas de diálogo.

Qual a definição de Artificial Intelligence Markup Language (ou AIML):

Uma linguagem de marcação baseada em XML para construção de chatbots por correspondência de padrões.

Um algoritmo estatístico baseado em cadeias de Markov.

Uma técnica de aprendizado profundo utilizada em modelos generativos.

Uma ferramenta exclusiva para chatbots multimodais.

De acordo com a discussão sobre agentes, qual das alternativas caracteriza corretamente um “agente” no contexto apresentado?

Um programa capaz apenas de gerar texto sem interagir com o ambiente.

Uma entidade computacional que percebe seu ambiente e atua por meio de sensores e atuadores.

Um sistema que realiza exclusivamente tarefas bancárias automatizadas.

Qualquer modelo de linguagem de grande porte, independentemente de suas capacidades.

Explique em que sentido um chatbot pode ser entendido como uma instanciação específica de um agente. Em sua resposta, (a) apresente uma definição de chatbot, (b) apresente uma definição de agente e (c) discuta as diferenças e sobreposições entre esses conceitos, incluindo a distinção entre sistemas que apenas conversam e sistemas que também utilizam ferramentas externas (como navegação na Web, execução de código e interação com APIs).

Compare os chatbots ELIZA e ChatGPT considerando pelo menos quatro aspectos: (a) período histórico e contexto de surgimento, (b) técnica ou abordagem principal utilizada para gerar respostas, (c) tipo de tarefa ou objetivo conversacional para o qual foram concebidos e (d) limitações em termos de compreensão de linguagem, contexto e emoções. Finalize discutindo por que ambos podem ser classificados como chatbots conversacionais.

Diferencie chatbots conversacionais e chatbots orientados a tarefas, ilustrando sua resposta com exemplos. Em seguida, analise o papel do fluxo conversacional nesses sistemas: descreva como fluxos de diálogo (por exemplo, árvores de decisão e fluxos de perguntas e respostas) são empregados em chatbots orientados a tarefas, e comente sobre como esses fluxos se relacionam com conceitos da Análise da Conversação, como tópicos conversacionais e coerência entre turnos.

Apresente e discuta a evolução das abordagens tecnológicas para a construção de chatbots, partindo de sistemas baseados em correspondência de padrões (como ELIZA e AIML/ALICE) até modelos neurais modernos baseados em Transformers e LLMs (como BERT, GPT e outros modelos recentes listados no capítulo). Em sua resposta, destaque: (a) a ideia central de cada abordagem, (b) vantagens e desvantagens principais e (c) impactos dessa evolução na qualidade das interações com os usuários.

Desenvolva um texto em que você (a) explique por que um chatbot, mesmo avançado, não pode ser considerado pensante nos mesmos termos que um humano, (b) descreva problemas práticos de construção e manutenção de chatbots (por exemplo, complexidade de fluxos condicionais, atualização de conhecimento, dificuldade de visualização de diálogos complexos) e (c) discuta o papel de ferramentas de autoria no-code na tentativa de tornar o desenvolvimento de chatbots mais acessível a usuários sem formação em programação.

Processamento de Linguagem Natural (PLN)

“Os ignorantes afirmam, os sábios duvidam, os sensatos refletem.”

Aristóteles

Objetivo Introduzir técnicas essenciais de PLN, como tokenização, lematização, POS tagging e NER, para capacitar o leitor a processar e analisar linguagem natural em projetos de chatbot; demonstrar o uso de expressões regulares; apresentar métodos de representação de texto, como Bag-of-Words, TF-IDF e embeddings; além disso, descrever como configurar o Python para executar os códigos.

Inteligência Artificial

A inteligência artificial (IA) é a força tecnológica mais transformadora do século XXI (Ribeiro 2025). Mas o que é IA? As definições de IA dependem do contexto e isso pode trazer confusão no entendimento e delimitação do tema. Menos abrangente, porém mais confuso ainda, é o termo “inteligência artificial”. Portanto, dado as diversas definições de inteligência artificial (IA), ou artificial inteligence em inglês, delimitaremos um pouco o escopo da inteligência em questão.

A IA aparece em nossa cultura de diversas formas, tais como, o HAL 9000 do filme “2001: uma Odisseia no Espaço”, clássico de Stanley Kubrick, ou como a IA do filme “Ela”, com o ator Joaquin Phoenix, onde um humano se apaixona por um sistema operacional.

Espero que você leitor seja um membro da espécie Homo-Sapiens. O termo “Homo-Sapiens” vem do latim e significa homem sábio (Wikipedia 2024a). A importância da sapiência (sinônimo de inteligência) é tamanha que define a nossa espécie. Porém, neste contexto, consideramos que um gato ou cachorro também é dotado de inteligência. Uma abelha é praticamente uma cientista (Wikipedia 2024b). Portanto, seremos mais contidos e reservados quanto ao significado do termo inteligência.

O que confunde é que inteligência e artificial são palavras que têm significado implícito para pessoas que não são da área de computação. Naturalmente, médicos, advogados, engenheiros (só para citar alguns) querem verificar como a “inteligência artificial” pode ser inserida na sua rotina diária. Meu dentista já quis saber como a IA iria afetar seus procedimentos odontológicos. Porém, ele nunca me perguntou em como a “Transformada de Fourier” poderia melhorar o seu dia-a-dia, mesmo sabendo que a transformada já é utilizada em vários domínios do conhecimento e com entusiasmo (Wikipedia 2024c).

A inteligência artificial da computação está mais relacionada com a capacidade de realizar coisas que seres inteligentes (tais como um gato, um bebê, uma abelha ou um humano) realizam, como, por exemplo, puxar a mão (ou pata) instantaneamente ao tocar em uma superfície quente, realizar uma prova objetiva de anatomia ou elaborar um recurso para a anulação de uma questão de concurso. Se um programa realiza uma ação geralmente realizada por uma entidade dotada de inteligência, ele pode ser encarado como um programa que simula uma inteligência artificial. Convenhamos que praticamente qualquer coisa cabe neste conceito.

Sobre este tema, o livro de Russell e Norvig (um dos livros mais lidos em todas as universidades do mundo sobre o tema) tem uma boa definição sobre o tema: “O campo da inteligência artificial [...] tenta não apenas compreender, mas também construir entidades inteligentes” (tradução nossa) (Russel and Norving 2013). Em outras palavras, a inteligência artificial da ciência da computação tem o audacioso objetivo de construir agentes dotados de inteligência.

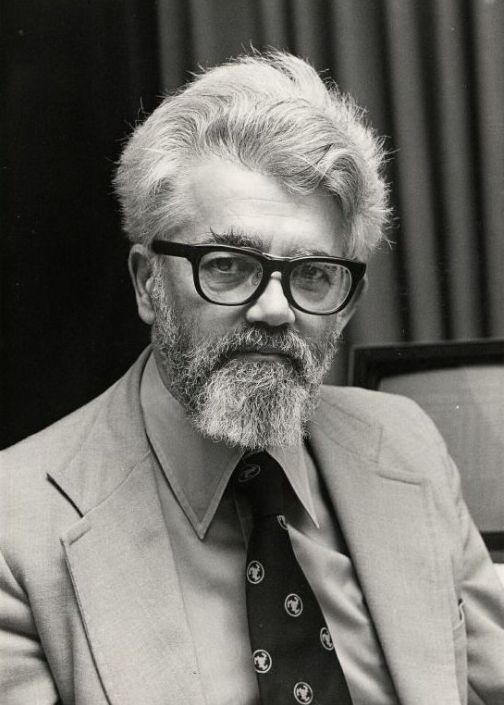

A origem do termo “inteligência artificial”, na ciência da computação, é geralmente atribuída a John McCarthy, professor de Matemática da Universidade Dartmouth College (blipblog 2024) (Figura 4.3). Ele organizou uma conferência com duração de oito semanas com outros colegas em 1956, alguns anos após a Segunda Guerra, e desde então o termo vem sendo utilizado para designar parte de conteúdos estudados em ciência da computação.

Um pouco antes, o artigo seminal de Alan Turing, com quem John McCarthy trabalhou em conjunto, já apresentava reflexões sobre a inteligência que uma máquina poderia possuir (Turing 1950). No entanto, a inteligência artificial aparece na literatura há milhares de anos; um exemplo é o Gigante Talos de Creta, um autômato proveniente da mitologia grega (Pickover 2021).

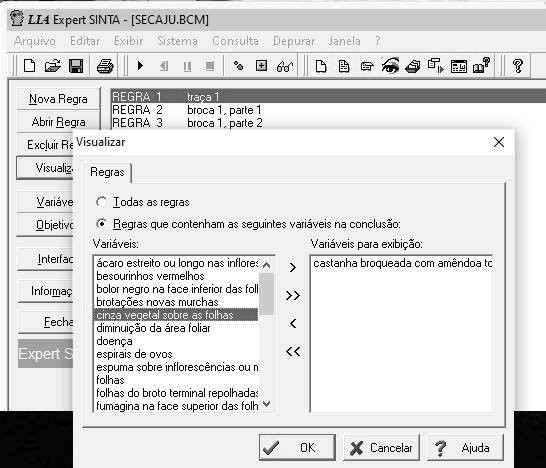

Foi na década de 1970 que o uso da inteligência artificial começou a ser mais difundido. Uma das primeiras abordagens com relativo sucesso foi os Sistemas Especialistas (SE). Eles dependiam dos especialistas do domínio para transformar o conhecimento tácito (baseado em sua experiência) em explícito (formalizado, documentado), que era então codificado na forma de regras em lógica formal. O processo de aquisição desse conhecimento acabou sendo um grande obstáculo na adoção em massa dessa abordagem. Veja um exemplo de software que implementa um motor de inferência baseado na teoria dos SE na Figura 4.4.

A superação de algumas limitações (tais como o aumento da capacidade de processamento e armazenamento dos computadores, a geração de grandes volumes de dados, novidades científicas e tecnológicas, chips supercondutores e a eficiência energética) permitiu o avanço de outras técnicas. Uma das técnicas que têm ganho notoriedade, por causa desses avanços, é o Aprendizado de Máquina.

Aprendizado de Máquina